摩尔线程Torch-MUSA v2.7.0发布,全面加速AI训练与推理。

11月28日,摩尔线程正式发布其为PyTorch深度学习框架打造的MUSA扩展库——Torch-MUSA v2.7.0。这一新版本在功能集成、性能优化以及硬件支持方面实现了显著突破,标志着国产GPU生态在AI计算领域持续加速演进。值得注意的是,在短短一个月内,Torch-MUSA连续推出了v2.5.0和v2.7.0两个重要更新,展现出团队高效的研发节奏与对开发者生态的高度重视。

据官方介绍,自v2.5.0版本起,Torch-MUSA已实现与PyTorch主版本号同步命名,此举极大地方便了开发者进行版本识别与依赖管理,降低了迁移和维护成本。此次发布的v2.7.0不仅延续了这一策略,更进一步集成了muSolver与muFFT等高性能计算加速库,显著提升了在科学计算、信号处理等复杂任务中的执行效率。从技术角度看,这类底层数学库的深度融合,是构建完整AI软硬协同体系的关键一步,也反映出摩尔线程正逐步补齐生态短板。

尤为值得关注的是,新版本首次在面向边缘计算的SoC设备中引入对统一内存设备(UMM)的支持。基于Arm架构的UMA(统一内存寻址)设计,使GPU与CPU能够共享同一物理内存空间,从而有效减少主机与设备间的冗余数据拷贝,降低整体内存开销。这一改进对于资源受限的边缘端AI推理场景意义重大——它不仅能提升能效比,还为轻量化模型部署提供了更强的技术支撑,有望推动国产GPU在智能终端、工业控制等边缘计算领域的落地应用。

Torch-MUSA v2.7.0在算子层面也实现了大幅扩展。新增支持ilshift、irshift、angle、logit、ctcLossTensor及其反向传播等多个常用算子,并补充了基础Sparse(CSR)格式操作和更多量化算子,增强了对稀疏计算与低精度推理的支持能力。这些细节虽不显眼,却是保障主流模型兼容性的“基石”。特别是修复torch.norm形状错误、解决空输入下argmax/argmin异常等问题,体现出开发团队正在积极回应社区反馈,稳步提升系统稳定性与用户体验。

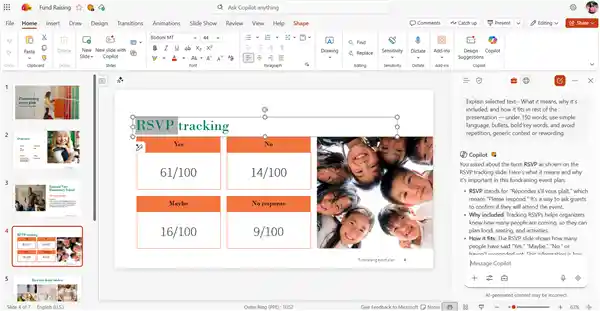

在性能优化方面,新版对var/std、pad、convolution3d、layer_norm等高频操作进行了效率调优,这对于训练大规模神经网络具有实际价值。同时,C++扩展中新增tensor.is_musa()方法,也为第三方库开发者提供了更友好的接口支持。系统级功能上,开放torch.musa.mccl.version()接口及支持获取当前BLAS句柄,增强了调试与多卡通信的能力;而FSDP2流水线并行策略的优化,则有助于降低大模型训练时的内存占用,显示出摩尔线程正逐步向高端AI训练场景迈进。

目前,Torch-MUSA专属支持的算子总数已超过1050个,且持续保持与最新MUSA SDK(4.2.0至4.3.0及以上版本)的兼容性。这种快速迭代的能力,反映出摩尔线程在软件栈建设上的投入力度。尽管相较于CUDA生态仍有差距,但其发展速度不容小觑。尤其是在当前国产替代需求日益强烈的背景下,一个稳定、高效、开源的深度学习框架支持体系,已成为衡量国产GPU成败的核心指标之一。

可以预见,随着下一版本计划支持PyTorch 2.9.0,Torch-MUSA将继续紧跟主流框架演进节奏。这不仅是技术层面的追赶,更是生态话语权的争夺。在一个由英伟达长期主导的生态系统中,摩尔线程通过持续输出高质量的开源工具链,正在悄然构建属于自己的开发者护城河。长远来看,能否赢得开发者的心,或许比芯片参数本身更为关键。

Torch-MUSA开源地址:https://github.com/MooreThreads/torch_musa