智融视界2025年10月09日 10:42消息,蚂蚁集团发布万亿参数开源模型Ling-1T,多项指标位居开源模型前列。

10月9日,据消息,蚂蚁集团今日正式推出其最新研发的万亿参数通用语言模型——Ling-1T。Ling-1T作为蚂蚁百灵大模型Ling2.0系列的首款旗舰产品,也是蚂蚁百灵团队目前推出的规模最大的、性能最强的非思考类大模型。

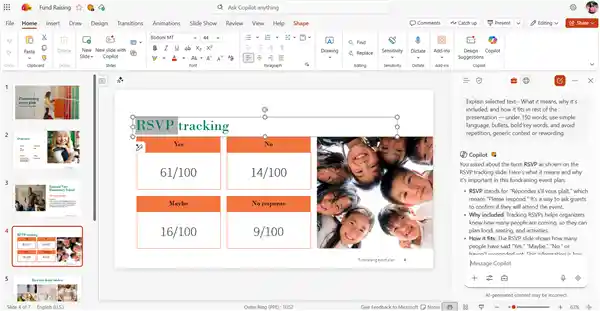

测评显示,在有限输出Token的约束下,Ling-1T在多项复杂推理基准测试中取得了当前最优的表现,展现出在高效思考与精准推理之间出色的平衡能力。同时,在代码生成、软件开发、竞赛数学、专业数学以及逻辑推理等多个高难度任务中,Ling-1T均表现出色,多项关键指标位居开源模型前列。 从技术角度看,Ling-1T的突破不仅体现了模型架构与训练策略的进步,也反映出在资源受限环境下实现高性能推理的可能性。这一成果为实际应用场景中的模型部署提供了更多可能性,尤其在需要快速响应和精确输出的领域具有重要意义。

在AIME25竞赛数学榜单测试中,Ling-1T以平均4000Token的消耗实现了70.42%的准确率,表现优于Gemini-2.5-Pro,后者在平均5000Token的消耗下准确率为70.10%。可以看出,Ling-1T在保持较高准确率的同时,有效降低了计算资源的使用,体现出更强的推理效率和精度平衡能力。 从技术角度看,这一结果反映出模型在处理复杂数学问题时,不仅需要强大的算法支持,还需要高效的资源调度能力。Ling-1T的表现说明其在优化模型结构和提升推理质量方面取得了显著进展,这对未来类似任务的模型开发具有重要参考价值。

据蚂蚁百灵团队透露,Ling-1T在Ling2.0架构的基础上进行优化,在20T tokens高质量、高推理浓度的语料上完成预训练,支持最高128K的上下文窗口。通过“中训练后训练”的演进式思维链(Evo-CoT)技术,模型在高效思考和精准推理方面得到了显著提升。 从技术发展角度看,Ling-1T的推出体现了大模型在持续优化与迭代中的进步。尤其是在推理能力和上下文处理方面,这一升级不仅提升了模型的实际应用价值,也为更复杂的任务提供了更强的支持。这种基于已有架构的深度优化,展现了技术积累与创新结合的重要性。

蚂蚁百灵团队表示,在研发万亿级旗舰模型的过程中,多次发现:随着模型规模的扩大和推理能力的增强,往往会呈现出令人惊喜的跨领域泛化效果。例如,在智能体工具调用任务BFCLV3中,Ling-1T在训练阶段并未引入大量操作轨迹数据,仅通过少量指令微调,就实现了约70%的调用准确率,体现出出色的推理迁移与泛化能力。Ling-1T能够准确理解复杂的自然语言指令,自主完成综合性任务:将模糊的逻辑问题转化为功能完整的可视化组件,为多端环境生成高兼容性的前端代码,或根据指定风格与语气撰写营销文案、文学续写及多语种文本。团队认为,这些能力构成了通用智能体的核心基础。

蚂蚁百灵团队表示,尽管Ling-1T在高效推理、跨领域泛化能力以及训练效率方面取得了明显提升,但仍存在一些不足之处。

attention 架构仍基于 GQA

在超长上下文和复杂推理任务中表现稳定,但整体推理成本相对较高。未来计划引入混合注意力架构,以提升训练与推理效率,同时降低对算力的需求。 从技术发展的角度来看,当前模型在处理复杂任务时展现出的稳定性值得肯定,但高成本问题也反映出优化空间。混合注意力架构的引入,有望在保持性能的同时,实现更高效的资源利用,这将有助于推动模型在实际应用中的普及与落地。

智能体能力仍需强化

当前版本在多轮交互、长期记忆和复杂工具使用等方面仍有限,近期将持续提升工具理解与使用能力,增强模型的主动性与泛化能力。

指令遵循与身份认知问题

在某些场景中,仍可能存在指令执行不准确或角色定位不清的情况。未来将通过强化身份对齐和安全微调来提升模型的一致性。

未来版本将持续在架构设计、推理能力以及对齐机制等方面进行优化升级,推动Ling系列向更高级别的通用智能迈进。

附开源仓库和体验页面:

HuggingFace:https://huggingface.co/inclusionAI/Ling-1T

ModelScope:https://modelscope.cn/models/inclusionAI/Ling-1T

GitHub:https://github.com/inclusionAI/Ling-V2

Ling chat(国内用户):https://ling.tbox.cn/chat

ZenMux(海外开发者,提供 Chat 测试与 API 等能力):https://zenmux.ai/inclusionai/ling-1t