豆包大模型1.6-vision发布,首个支持调用工具的视觉深度思考模型,开启AI新纪元。

10月1日获悉,火山引擎昨日正式发布豆包大模型1.6-vision,这是豆包大模型系列中首款具备工具调用功能的视觉深度理解模型。该模型在通用多模态理解和推理能力方面有显著提升,并支持ResponsesAPI,以更具性价比的方式更好地满足用户在视觉识别精度方面的高级需求。

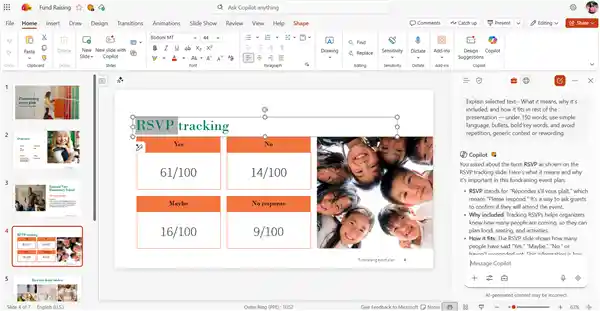

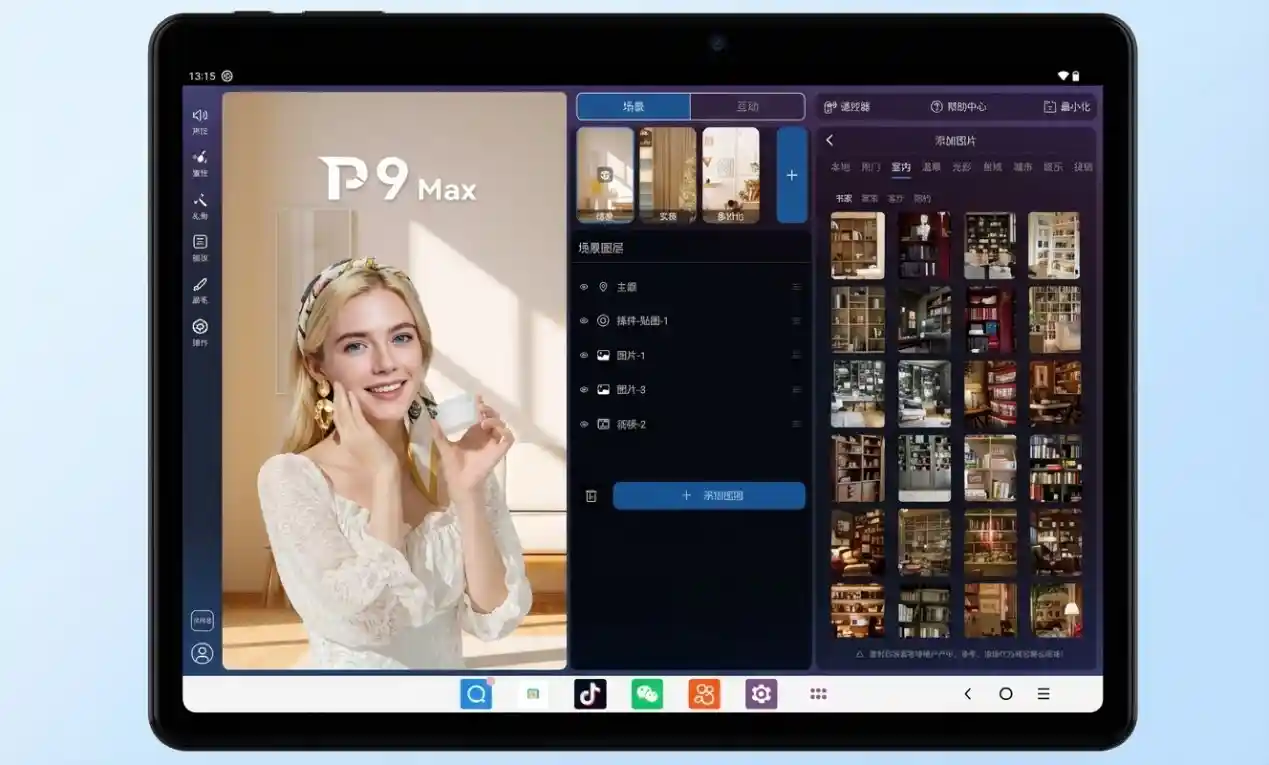

据官方介绍,豆包大模型1.6-vision通过其独特的工具调用能力,能够将图像信息有效融入其思维链中,实现对图片的定位、剪裁、点选、画线、缩放、旋转等精细操作。它模拟人类“从全局扫描到局部聚焦”的视觉推理过程,在提升推理过程可解释性的同时,也显著提高了图像处理的效率与准确性。 我认为,这种技术的进步不仅提升了AI在图像理解与处理方面的能力,也为后续在智能辅助设计、医学影像分析、自动驾驶等多个领域的应用提供了更坚实的基础。随着这类技术的不断成熟,人机交互将变得更加自然和高效。

与上一代Doubao-1.5-thinking-vision-pro相比,豆包大模型1.6-vision在综合成本方面下降了约50%。以用户最常使用的32K输入输出场景为例,成本由原来的5.25元降至2.6元。

注意到,今年6月,火山引擎推出了豆包大模型1.6版本,该版本通过增强多模态思考能力,进一步提升了对复杂场景的理解与处理能力。这一更新表明企业在AI技术上的持续投入,尤其是在多模态融合方面取得了实质性进展。随着人工智能应用场景的不断扩展,具备更强综合理解能力的模型将更贴近实际需求,推动行业向更高层次发展。