DeepSeek发布V3.1重大升级,支持128K超长上下文,大幅提升理解与生成能力,引领AI技术迈向新纪元。

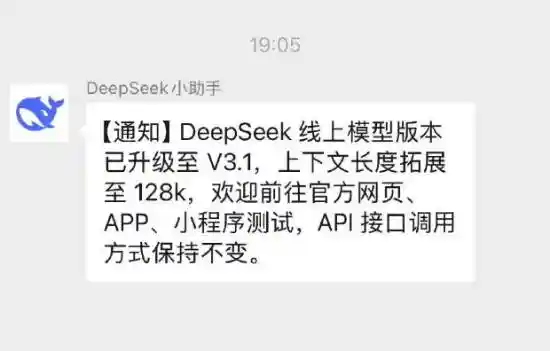

今天晚上,DeepSeek宣布其在线模型已完成最新一轮版本升级,正式推出V3.1版本。此次更新最受关注的亮点在于上下文长度的显著提升,已扩展至128k,意味着模型在处理长文本时具备更强的记忆力与连贯性。用户现可通过官方网站、手机应用或小程序即刻体验新版本,而API接口的调用方式保持不变,确保了开发者使用的稳定性与延续性。

这一技术升级标志着DeepSeek在大模型长上下文能力上的又一次实质性进步。128k的上下文长度,相当于可处理超过十万字的连续文本,对于需要深度理解长文档的场景——如法律合同分析、学术论文解读、大型代码库调试等——将带来显著的效率提升。尤其在多轮对话中,模型能够更准确地记住早期对话内容,减少“遗忘”或逻辑断裂现象,极大增强了人机交互的自然度与可信度。从用户体验角度看,这不仅是参数的提升,更是实际应用场景中智能水平的质变。

值得注意的是,官方明确表示此次V3.1属于常规版本迭代,并未包含外界高度期待的R2版本相关功能。结合DeepSeek过往的产品发布节奏来看,在R2正式亮相前,预计还将推出V4版本作为技术铺垫。这意味着R2可能承载更重大的架构革新或能力跃迁,而当前的更新更像是为后续重磅发布夯实基础。作为观察者,我们认为这种“稳中求进”的迭代策略值得肯定:在确保服务稳定的前提下持续优化核心能力,既满足现有用户需求,也为未来突破预留空间。